査読はどうあるべきなのか

学術雑誌が紙媒体を用いて論文を出版していた頃、紙面による制限ゆえに、掲載する論文を専門家による査読で選別することに意味があった。しかし、インターネットの普及とともに、低コストの出版が可能となり、こうした査読システムは時代遅れとなった。これからの時代には、出版と評価を切り離し、出版は査読なしで即座に行い、評価は出版後に計測される被引用度などの指標に基づいて行う新たなシステムが求められる。このページでは「評価される人ほど評価する能力がある」というエリート主義の原則と「評価する人の数が増えるほど不正や偏りは少なくなる」という民主主義の原則という対立する二つの原則を取り入れた再帰的投票システムを提案する。

目次

1. 査読システムの必要性

査読(peer review)とは、専門を同じくする研究者仲間(peer)による論文の批評(review)のことで、学術雑誌の編集者はこれを参考にして投稿された論文を掲載するかどうかを決める。研究助成金の選考委員が研究者の申請に基づいて支給を決める時も、査読システムが使われることがある。論文を掲載する学術雑誌の紙面には制限がある。研究助成金も限られた金額しかない。研究者たちは、これらの限られた資源をめぐって競争するので、その選抜を決めるための評価システムが必要であり、査読システムは、この機能を果たすために導入されている。

査読は、1665年に英国学士院が発行し始めた学術雑誌『哲学紀要』で、出版に権威を与えるために、審議会のメンバーが最初に検閲するようことを命じたのが起源と言われている。1752年には、英国学士院は論文委員会を設立し、そこで出版するすべての記事を査読するようになったが、こうした制度は何世紀もの間例外的であった。外部の研究者に査読を依頼することが学術雑誌の編集における必須のプロセスとして定着したのは、比較的新しく、20世紀の中頃になってからのことである[1]。

査読システムにおいては、通常、査読者は論文の執筆者あるいは助成金の申請者に対して匿名である。査読者は執筆者/申請者と同じ分野の研究仲間であり、査読者が匿名でない状態で否定的な査読結果を下すなら、研究仲間から恨まれ、逆の立場になった時に復讐されてしまう。だからといって仲間同士の褒め合いになると、査読は本来の機能を発揮しない。だから匿名性が採用されているのである。

執筆者/申請者が査読者に対して匿名になることもある。これはそうではないシングル・ブラインドに対してダブル・ブラインドと呼ばれる。属人的要素によって査読が影響されないようにするための工夫であるが、専門内の研究仲間の数が限られる時、論文本文や参考文献のリストを読んだだけで誰だか見当がつくことも多い。匿名性を徹底しようとすると、論文の内容を一部改編する必要もあり、手間がかかるので、ダブル・ブラインドは、シングル・ブラインドほど一般的ではない。

研究者が、他の研究者の率直な批評に耳を傾け、論文を改善しようとすることは有意義なことである。査読システムのおかげで、研究者は一定の基準以上の論文だけを読むことができるし、また研究助成金の配分や研究者の昇進を恣意的でない方法により行うことができる。それゆえ、査読システムとそれに基づく研究資源の配分は、世界中で採用され、今日に至っているのである。

2. 査読システムの諸問題

査読システムは、学術雑誌の質を高める上で重要な役割を果たしてきたと評価されている一方で、以下のような問題も指摘されている。

2.1. 出版までに時間がかかる

学術雑誌の編集者は、提出された論文の内容を吟味し、掲載にふさわしいと判断すると、その分野で評価されている専門家2-3人を査読者として選び、査読を依頼する。無条件で掲載されるケースはまれで、通常は、査読者が論文に意見を加え、それに基づいて論文を書き換えることが提出者に要求される。こうした面倒なプロセスを経ているため、提出された論文が学術雑誌に掲載され、出版されるまでには長い時間がかかる。半年から一年かかる場合もある。科学技術が日進月歩で進歩している時代にあって、公開に時間がかかるということは大きな問題である。

このため、研究者は、より早い段階で意見交換することができるように、学術雑誌に提出するに先立って、論文をプレプリント・サーバのレポジトリで公開するようになった。学術雑誌は、二重投稿を禁止しているが、例えば、『ネイチャー』は、「原稿の提出前のバージョンあるいは提出した本来のバージョンを個人ブログや協働ウィキやプレプリント・サーバにいつ投稿してもよい[2]」と言っており、査読のないレポジトリでの公開が提出を妨げるものではないことを明記している。

プレプリント・サーバの代表例は、arXiv である。1991年に、核兵器開発で有名なロスアラモス国立研究所が開発し、今では、コーネル大学図書館が運営を引き継いでいる。2011年現在、素粒子物理学(高エネルギー物理学)の論文の 97% は arXiv 上にあり、ほとんどの研究者はここで論文を読み、学術誌に出版された論文を読む研究者は10%以下しかいない。だから、この分野では学術誌は、もはや情報発信の役割を果たしていない[3]。この他、全領域をカバーするプレプリント・サーバに viXra.org, Philica, Science Paper Online などがある。

2.2. 機密情報がライバルに漏れる

この問題は、提出から出版まで時間がかかることによって起きる。査読者は、分野を同じくする研究者なので、提出者からするとその分野のライバルでもある。研究者がプライオリティ(一番乗り)を巡っていかに熾烈な争いを繰り広げているかは言うまでもない。だから出版前に画期的な知見を含む論文をライバルに読ませるということは、ある企業が出願した特許の審査をその企業のライバルにさせるようなもので、長い時間をかけて審査をしているうちにライバルに先を越されるというリスクが生じる。学術雑誌は、査読者が情報漏洩を行うことを禁止しているが、禁止すれば必ず防げるというものではない。

このため、研究者の中には、情報漏洩を防ぐために手の込んだトリックを用いる者もいた。1987年にポール・チュー(朱經武)は、従来用いられていたランタンの代わりにイットリウムを用いることで、高温(77K)での超伝導を実現することに成功した[4]。チューは、しかしながら、この情報が査読中に漏れることを恐れ、Y(イットリウム)を Yb(イッテルビウム)と意図的に誤記し、最終的な校正の段階でそれを修正した。実際に、論文の情報は公刊前にライバルの研究グループに漏れていた[5] が、チューはこのトリックによりプライオリティを守ることに成功した。

こうした情報漏洩のリスクも、プレプリント・サーバを用いることで減らすことができる。すなわち、論文公開時に著者の署名と公開日時が記録されるので、それによってプライオリティが守られる。個人サイトで論文を公開した場合、内容や公開日時の改竄が疑われるので、プライオリティが守られない可能性がある。だから、プライオリティを重視するなら、投稿者が内容や公開日時を勝手に変更できない、第三者が管理しているレポジトリに投稿した方が賢明である。

2.3. 出版後の改変が困難

いったん出版した論文は、後で内容を改変することは困難である。特に紙媒体に印刷する場合は、出版コストが高くつくので、改変した論文を再掲することはしない。せいぜい正誤表や補遺を追加することができるだけである。そもそも査読システムの目的は、論文に権威を与えることだから、権威を与えた後でむやみに内容が改変されては困るのである。だからこそ、出版まで長い時間をかけなければいけないのだが、長い時間をかけたからといって間違いをゼロにすることができるわけではない。また、論文の著作権は学術雑誌の出版社に譲渡されるのが普通であり、その場合、出版社に無断で他のメディアに転載することはできない。論文を部分的に修正して、他の学術雑誌に投稿することは自己剽窃(self-plagiarism)と呼ばれ、業績を水増しする不正行為として禁止されている。

これに対し、プレプリント・サーバでは公開後の訂正は簡単にできる。例えば、arXiv では、いつでも訂正した論文を新バージョンとして旧バージョンの論文と置き換えることができる[6]。プライオリティを重視しつつ、間違いを柔軟に訂正できるようにするには、ウィキサイトにおけるように、誰がいつ最初に論文を書き、それに対して誰がいつコメントをし、それに応じていつどの箇所を訂正したかがすべて記録されて残ることが理想的であり、そしてそれをオンラインのレポジトリで実現することは難しいことではない[7]。

2.4. 編集コストがかかる

プレプリント・サーバのコストは、事実上サーバの維持費ぐらいなので、低額である。arXiv の場合、論文のカテゴリーを変更したり、科学論文とは言えない不適切な投稿を削除したりするモデレイターがいるが、ボランティアなので、編集コストはかかっていない。arXiv の運営費用は、2010年現在40万ドルで、コーネル大学図書館が主として負担しており、投稿者も閲覧者も無料で利用ができる。但し、ヘビーユーザの研究機関には寄付が求められている[8]。

査読に基づく編集を行う学術雑誌の場合、サーバのコストに加え、編集のための人件費などの経費が加わる。紙に印刷するなら、さらにコストがかかる。商業出版なら、経費以上に利益も稼がなければいけない。他の分野の雑誌とは異なり、学術雑誌の場合、原稿の執筆も査読も研究者が無料で行い、それでいて図書館に高額で売りつけることができるので、利益率は高く、60% を超えるところすらある[9]。そもそも、学術雑誌の出版社に対してただ働きをしている研究者の給料にも、高額な学術雑誌を購入している図書館の予算にも、公的資金が使われているのが普通であり、それでもって営利企業の利益率が高くなることを問題視する人もいる[10]。

最近では、PLOS のように、学術雑誌の論文をオンライン上で課金せずに公開するオープンアクセスの動きがみられる。例えば、『ネイチャー』は、2012年9月24日に、arXiv と競合する素粒子物理学の分野を全面的にオープンアクセス化することを決めた[11]。オープンアクセスが普及すると、大学等に所属していなくても無料で学術論文が読めるようになるので、一般の読者にとってはありがたいことであるが、オープンアクセスを実現するには、論文の投稿者が高額な費用、例えば、『ネイチャー・コミュニケーションズ』だと637350円[12] を負担しなければならない。オープンアクセスが実現すれば、図書館の予算を削減することができる半面、雑誌掲載のための費用が増えるので、トータルではあまりコスト削減にはならない。

2.5. 査読が不適切であることがある

学術雑誌における査読の結果や編集者の判断は、必ずしも正しいとは限らない。学術雑誌は(1)掲載するべきでない論文を掲載する誤謬と(2)掲載するべき論文を掲載しない誤謬という二種類の誤謬を犯すことがある。

(1)は、査読が意図的な捏造や改竄が含まれる論文の出版を防ぐことができない場合が典型的な事例である。ヤン・ヘンドリック・シェーン、ファン・ウソク、ディーデリック・スターペルなどによる最近の事例を見ればわかるように、『サイエンス』や『ネイチャー』といった超一流の科学雑誌の査読ですら捏造を見抜くことができなかった。それは査読者や編集者たちがたまたま不注意だったからということはない。査読者にできることは、読んだだけでわかる単純なミスの指摘を除けば、せいぜい過去の研究成果を踏まえているかどうか、独創性があるかどうかの判断ぐらいで、編集者も読者が興味を持ってくれるか否かぐらいしか考えていない。科学雑誌も認めるように、「巧妙な詐欺を査読で発見することは、事実上ほとんど不可能である[13]」。査読は無償サービスであり、再現実験による追試といった費用のかかる検証はできない。だから、意図的でない間違いがあっても、それを見抜けないことがしばしばある。

(2)に関しては、後にノーベル賞を受賞する画期的な業績の論文が20本以上も査読で却下されたという事実[14] を挙げれば十分であろう。堅実な学術雑誌は、査読者としてその分野の権威と呼ばれている長老を選好するものだが、そういう大御所的な研究者には、古い考えに拘束され、新しい考えを予断と偏見で排除する傾向があり、その結果、支配的なパラダイムの転換が抑制されるという事態が憂慮される。他方で営利企業が発行している商業誌の中には、センセーショナルな内容で売り上げを伸ばそうとするあまり、良質ではあるが派手ではない論文を却下するところもある。様々な編集方針の雑誌があることで、全体としての多様性が維持されているという見方もできるが、どの雑誌でも、少数の者が意思決定を行っているので、それに伴う偏りを免れることができない。

3. 査読システムの諸問題の解決方法

以上、査読システムが抱える五つの問題を確認したが、最初の四つは、arXiv のようなサード・パーティが運営するプレプリント・サーバの使用により解決可能である。科学が進歩するためには(1)研究者が他の研究者に対して論文を発表する機能(2)その論文をめぐって研究者どうしで意見交換をする機能(3)研究資金やポストを配分するために研究者の業績を評価する機能という三つの機能が必要であり、プレプリント・サーバは、最初の二つの機能を果たすが、三番目の機能は果たさない。だから、arXiv の主要分野である物理学でも、査読付きの学術雑誌が、論文を評価する機能の担い手として、今でも発行されているのである。

しかし、論文の価値をそれが掲載されている学術雑誌の価値で判断するのは本末転倒である。学術雑誌の価値を測る指標としては、トムソン・ロイターのインパクト・ファクターが代表的であるが、この指標は、頻繁に引用される論文ほど価値があるという前提の下に学術雑誌の価値を測定している。例えば、2012年のある雑誌のインパクトファクターは、

雑誌が 2010-2011年 に掲載した論文が 2012 年に引用された延べ回数 ÷ 雑誌が 2010-2011 年に掲載した論文

で計算される。つまり、被引用度で論文の価値を計測し、掲載されている論文の価値で学術雑誌の価値を測定しているのだから、学術雑誌の価値を媒介としなくても、論文の価値は直接計測できるということである。一流雑誌に掲載されているから引用するという権威主義とか、みんなが引用しているから自分も引用するというバンドワゴン効果とかもあるだろうが、それらは二次的、三次的なものであって、本来的な判断基準ではない。

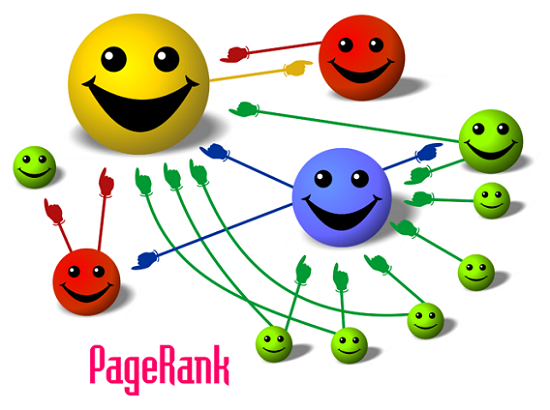

グーグルのページランク(PageRank™)も、多くのページからリンクされているページほど価値があるというインパクト・ファクターと似た考えに基づいてウェブページの格付けを行っている。但しそのアルゴリズムはもっと複雑で、以下の図に描かれているように、ページランクの高いページからのリンクは、そうでないリンクよりも高く評価するという再帰的なルールを用いている。

その結果、ランクの低いサイト同士が相互リンクをしても、ページランクが上がらない仕組みとなっている。また、リンク集のように、ページ内に大量にリンクがある場合、その価値は下がる。学術雑誌での被引用回数で論文を評価する時にも同じ方法を用いることが提案されたことがあった[16]。

ページランクのような再帰的方法を用いても、被引用回数だけで論文の価値を正確に測定できない場合がある。ジョージ・シェルドリックの2008年の論文“A short history of SHELX”は、結晶構造を決定するために SHELX を実装したプログラムを使った人が引用するべき論文であったために、被引用回数が 5624 回と異常に大きくなった。その結果、これを掲載した学術雑誌『Acta Crystallographica Section A: Foundations of Crystallography (アクタ・クリスタログラフィカ・セクションA)』の 2009 年のインパクト・ファクターが 2008 年の 2.051 から 49.926 へと急上昇し、『サイエンス』や『ネイチャー』を抜いてトップに躍り出て、話題になった[17]。いうまでもなく、シェルドリックの論文にそれだけ価値があったということではない。

シェルドリックのような問題は、グーグルのページランクでも起きる。例えば、ブログソフトウェアの WordPress では、サード・パーティが制作したテーマを自由に選んで、サイトをお気に入りのデザインにすることができるが、そうするとそのテーマを制作した作者のサイトへのリンクがすべてのページのフッターに自動的に挿入される。テーマが人気なら、そのページへのリンク数は膨大になり、リンク先のページは過大評価となる。また、これとは別に、批判や非難のために引用やリンクが行われることがしばしばあるという問題もある。こうした問題は、ウェブページへのリンクあるいは学術論文の引用は、必ずしもそれが良いという意思表示の結果行われる投票ではないというところに起因している。

学術雑誌での被引用回数で論文の価値を測定することは、ウェブ上での被リンク数でウェブページの価値を測定することと似ているが、前者では、後者とは異なり、限られたごく一部のエリートしか評価に参加することができない。一般的に言って、職業的な研究者は、アマチュアの研究者を自分たちのコミュニティに入れたがらないものである。例えば、arXiv は、不適切と彼らが判断した記事を排除し、素人のサイトと一線を画すために、2004年1月17日に、最初の論文を投稿する前に他の既存のユーザから推薦を受けることを義務付ける制度を始めた[18]。この推薦制度は、モデレイター制度と同様に論文の質を高めるのに役立っていると arXiv は主張している。arXiv は、査読付き雑誌ではないものの、伝統的なエリート主義に固執している。

ある科学者たちは、こうした推薦制度やモデレイター制度に反発して、viXra.org という新しいサイトを立ち上げた。arXiv とスペルが逆であることからもわかるように、彼らの編集方針は、arXiv の編集方針とは逆である。実際、viXra は、オープンなレポジトリで、そこに記事を掲載するために推薦はいらないし、記事の正しさや著者の資格について問われることはない。完全に自由なプレプリントサーバであるがゆえに、職業的な科学者がここに掲載された論文を読むことはほとんどない。

こうしたエリート主義には、問題もいろいろある。すなわち、参加者と評価者の数が少ないために、データが不足したり、評価基準が仲間内で固定されたり、工作活動に対して脆弱であったり[19] といった弊害が生じる。こうした弊害を解消するために、ネット上での一般の人々の評価を反映させるオルトメトリクス(altmetrics)が提唱されている。オルトメトリクスとは、非伝統的な(alternative)評価指標(metrics)という意味である。具体的には、ソーシャルメディアでの評価、Mendeley などの学術論文引用管理ソフトウェアでの使用状況、ソーシャルブックマーク、オンライン上でのリンクなどのデータから研究者の業績を評価する。

オルトメトリクスによって、私たちは大衆による査読を実現することができる。査読者二人の意見を何か月も待たなくても、一本の記事の影響力は、一週間のうちに行われる何千という会話やブックマークによって測定されるかもしれない。これは、PLoS ONE, BMC Research Notes, BMJ Open といったオープンアクセスの雑誌における素早い批評を増やすことで、短期間のうちに伝統的な査読を補完することになりそうだ。将来的には、参加者が増えて、貢献する専門家の身元確認をするより良いシステムができて、オルトメトリクスで査読が完全にできるようになるかもしれない。インパクト・ファクターとは異なり、オルトメトリクスは雑誌ではなくて記事それ自体のインパクトを反映する。引用による指数とは異なり、オルトメトリクスはアカデミズム外部のインパクト、影響はあるが引用されることのない仕事のインパクト、査読の対象にならないソースのインパクトを追跡する[20]。

このように述べ、altmetrics.org は、評価の対象として、論文だけでなく、論文に対するコメント、データセット、コード、実験設計、ブログ、マイクロブログ、コメント、論文への書き込みなどをも含めることを提案している。

たしかに、研究者のコミュニティをオープンにし、評価対象の範囲を拡大し、貢献者と評価者の数を増やせば、データの数が増え、工作活動がしにくくなるし、業績内容や評価基準も多様化するだろう。しかし、オルトメトリクスによる評価だけで研究資源の配分を行えば、研究者たちはわかりやすくて大衆受けしそうな内容の研究ばかりをして、専門的で難解な研究を疎かにするという弊害が生じる。また評価対象の範囲を広げすぎると、科学とは関係のないコンテンツまでが評価の対象になってしまう。だから、評価対象の範囲を研究者用のメディアに限定し、そして、論文における被引用回数の度合いをページランク的に評価したメトリクスを主とし、オルトメトリクスの方は従として、総合的な業績評価指数を作るべきである。

また、研究助成金やポストなどの研究資源の配分は、その重要性を考えれば、引用、リンク、ブックマークなどの投票代替的行為から機械的に作られる指標だけで決めるべきではなく、直接的な投票で決めるべきだ。機械的に作成される指標はスクリーニングに便利だが、スクリーニングで選抜されたトップクラスのコンテンツの候補が本当に優れたものであるかどうかは、実際に内容を読んで確かめてみないと判断が付かない。さもないと、シェルドリックの論文のようなケースが発生してしまう。

4. 査読システムに代わる新たなシステム

以上の点を踏まえ、私は、以下のような再帰的投票システムを提案したい。

- まず、今述べた総合的な業績評価指数で論文やそれに対するコメントを評価し、それに基づいて研究者の個人評価指標を算出する。自然科学の論文の著者は複数であることが多いが、名前は貢献順に列挙されるので、貢献度に応じて指標を配分すればよい。執筆者側が配分比率を自主的に決めたい時には、公開時に、貢献度をパーセントで表示すればよい。

- 次に、研究者の格付けを行うためのオンライン投票を一年に一回行う。公的な研究助成金を受け取ったり、研究職への就職を希望したりする者は、必ず投票しなければならないものとする。それ以外の人でも、誰でも投票できるものとする。但し、成りすましなどの不正投票を防ぐために、本人確認の手続きが必要である。

- 各投票者は、個人評価指数に応じた票が配分され、申請があった論文のうち、自分が著者でない論文で、評価できるもの、自分の研究に役立ったものに投票する。投票は、例えば、100 票持っているなら、A 論文には 40 票、B 論文には 30 票、C 論文には 20 票、D 論文には 10 票というように、複数の論文に行うことができる。

- 投票者は、投票の際、投票する理由も書く。これは公開され、それに対する評価は次回の個人評価指標の算出に使われる。露骨な身贔屓の投票や不可解な理由での投票をすれば、その投票者は評価を下げることになる。このように、投票を通じて学術論文が評価されるだけでなく、その評価自体も評価されることにより、工作的な投票が阻止される。

- 投票結果は、その年の研究費やポストの配分に反映される。配分は通常国単位で行われているので、それぞれの国で希望者を募集し、応募者を得票順にランク付けして、助成金の額や研究者の就職や昇進を決めることになる。得票結果は、さらに、次の年の個人評価指数を算出する際にも用いられる。すなわち、個人評価指数を作成する際、その年のデータのみならず、前年の投票結果までもが反映される。

この再帰的投票システムは、「評価される人ほど評価する能力がある」というエリート主義の原則と「評価する人の数が増えるほど不正や偏りは少なくなる」という民主主義の原則という対立する二つの原則のもとに作られている。エリート主義の原則を重視しすぎると、従来のアカデミズムがそうであったように、閉鎖的な象牙の塔の中で旧態依然たる伝統が墨守され、研究が停滞する。科学のイノベーションを促すには、システムをオープンにして、異分野からの参入を認めなければならない。しかし、それにも限度がある。民主主義の原理を重視しすぎると、研究者たちは大衆迎合に走り、公的な研究助成金が占星術や超能力などの疑似科学の研究に使われるといったことが起きるだろう。だから、二つの対立する原則の間でバランスを取らなければいけない。

エリート主義の原則は、再帰的投票システムにおいては、その再帰性によって維持されている。評価指数はページランクと同様に、再帰的に定義され、投票も、翌年の評価指数の算出も再帰的に行われる。だから、このシステムにおいて、学界のエスタブリッシュメントがすぐに失脚するということはない。カルト教団のリーダーが、自分の疑似科学的な教説に権威を与えようと、信者たちを大量動員して工作活動をしても、評価指数の高い研究者からは認められないので、幾重にも重ねられた再帰性の壁に阻まれて、大量得票に成功しないだろう。

他方で、再帰的投票システムは、オープンな投票制を導入することで、従来のアカデミズムのシステムよりも民主主義の原理を大幅に取り入れている。その結果、疑似科学がオーソドックスな科学に参入するリスクが増えることは事実であるが、世間から「疑似科学」と呼ばれているからといって、最初から参入の可能性をゼロにするべきではない。そもそも科学と疑似科学の境界は曖昧であり、主流派の科学者から「疑似科学」と呼ばれて、全く相手にされていなかった学説が、後の時代には定説となるということもある。定説と大きく懸け離れているからといって、検証もせずに先入観から否定することは科学的な態度ではない。かつて『ネイチャー』が、ユリ・ゲラーの超能力を検証する論文を掲載した[21] が、それは非難されるべきことではない。

査読システムにおいては、査読者が復讐を恐れる必要がないように、匿名にする必要があったが、再帰的投票システムにおいては、その必要はない。どの個人にも他の研究者が論文を公開することを阻止する権限はないし、研究資源の配分を妨害する決定的な権力を持ってはいないのだから、恨まれることはない。査読システムでは、コメントは評価の対象にはならないが、再帰的投票システムでは評価の対象になる。たんなる同調コメントは評価されないが、批判的コメントは、それが的確であれば、評価される。学問的批判は、反論しても、受け入れても、ともに生産的な結果をもたらすのだから、本来恨まれる性質のものではない。

査読が意図的な捏造や改竄が含まれる論文の出版を防ぐことができないことは既に述べたとおりであるが、再帰的投票システムにおいてはどうか。まず、公開時にはチェックが行われないから、当然防ぐことはできない。しかし、権威ある雑誌で出版される場合とは異なり、意外な実験結果は疑われ、追実験が行われる。追実験による再現可能性の否定は、それ自体業績として扱われるので、研究者にはそれを行うモチベーションがある。再現可能性が否定されたら、最初の実験者は、実験の検証あるいは再実験を余儀なくされるし、それをしなければ、捏造や改竄が疑われる。意図的な捏造や改竄で研究資金や賞金を手にすると、詐欺に相当するので、刑法上の犯罪となる。再現可能性の検証は研究者の仕事であり、そこから先は警察の仕事である。

インターネットの普及に伴い、ヒエラルヒー型だった社会がネットワーク型へとフラット化している。インターネットは研究者間のコミュニケーション・ツールとしてスタートしたにもかかわらず、フラット化は後発のジャーナリズムと比べて遅れている。これは、ジャーナリズムでは、アカデミズムほど専門性が高くないからだろう。かつて、情報発信する職業的なジャーナリストと一般的な情報の消費者との間には明確な一線が引かれていた。そうした境界線は、個人のブログがマスメディアのサイトと同等に競争できるようになってから、消滅した。私が提案する再帰的投票システムは、研究者のコミュニティをもフラット化するであろう。

5. 参照情報

- ↑Wendy Wagner, Rena Steinzor. Rescuing Science from Politics: Regulation and the Distortion of Scientific Research. Cambridge University Press; 1 edition (July 31, 2006). p. 220-221.

- ↑“You are welcome to post pre-submission versions or the original submitted version of the manuscript on a personal blog, a collaborative wiki or a preprint server at any time." Nature. “Confidentiality and pre-publicity."

- ↑瀧川 仁. “素粒子物理学系ジャーナルのオープンアクセス化の試み." 国立情報学研究所.

- ↑Wu, Maw-Kuen, et al. “Superconductivity at 93 K in a new mixed-phase Y-Ba-Cu-O compound system at ambient pressure." Physical review letters 58.9 (1987): 908.

- ↑Rustum Roy & James R. Ashburn. “The perils of peer review," Nature 414, p. 393–394 (2001).

- ↑arXiv. “To replace an article." revision 0.3.4. Last modified 2019-01-04.

- ↑この原稿も非公開のウィキソフトを用いていて書いているので、いつどの箇所を訂正したかがすべて記録されて残る。しかし、それで書き込んだ私のプライオリティが守られるかというとそうはいかない。このサイトをホストしているサーバが私の管理下にあるので、日時を私が改竄したのではないかという疑いがもたれるからだ。個人管理のサイトでプライオリティを守ろうとするならば、Internet Archive のような第三者が管理しているサーバにキャッシュを残さなければいけない。すべてのコンテンツをアーカイブしているのではないので、完全ではないが、ある程度までは証明に使える。

- ↑Greg Landgraf. “Cornell Seeks Sustainable arXiv Support." American Libraries Magazine. February 18, 2010.

- ↑Richard Van Noorden. “Britain aims for broad open access." Nature 19 June 2012.

- ↑George Monbiot. “Academic publishers make Murdoch look like a socialist." The Guardian Monday 29 August 2011.

- ↑Richard Van Noorden. “Open-access deal for particle physics." Nature 24 September 2012.

- ↑Nature Communications.

“Open access options." Accessed on 20 Aug 2016. - ↑“detecting well-done fraud during peer review is nearly impossible in practice" Nature Neuroscience Editorial. “Can peer review police fraud?." Nature Neuroscience. 9, p. 149 (2006).

- ↑Nature Editorial. “Coping with peer rejection." Nature 425, p. 645 (2003).

- ↑FML. “PageRank.” Licensed under CC-BY-SA.

- ↑Pinski, Gabriel, and Francis Narin. “Citation influence for journal aggregates of scientific publications: Theory, with application to the literature of physics." Information processing & management 12.5 (1976): 297-312.

- ↑Jordan D. Dimitrov, Srini V. Kaveri, Jagadeesh Bayry. “Metrics: journal’s impact factor skewed by a single paper." Nature 466, p. 179 (2010).

- ↑“The arXiv endorsement system." arXiv.org.

- ↑Roger A. Brumback, MD. “Impact Factor Wars: Episode V—The Empire Strikes Back." Journal of Child Neurology. March 1, 2009.

- ↑“With altmetrics, we can crowdsource peer-review. Instead of waiting months for two opinions, an article’s impact might be assessed by thousands of conversations and bookmarks in a week. In the short term, this is likely to supplement traditional peer-review, perhaps augmenting rapid review in journals like PLoS ONE, BMC Research Notes, or BMJ Open. In the future, greater participation and better systems for identifying expert contributors may allow peer review to be performed entirely from altmetrics. Unlike the JIF, altmetrics reflect the impact of the article itself, not its venue. Unlike citation metrics, altmetrics will track impact outside the academy, impact of influential but uncited work, and impact from sources that aren’t peer-reviewed." altmetrics.org. “How can altmetrics improve existing filters?" version 1 – released October 26, 2010.

- ↑Targ, Russell, and Harold Puthoff. “Information transmission under conditions of sensory shielding." Nature 251.5476 (1974): 602.

ディスカッション

コメント一覧

イギリスのエコノミスト誌は、現在の学術雑誌には、人目を引く内容ではあるが、その真偽は疑わしい大量のゴミ論文が掲載されており、それが科学の進歩を阻んでいるという問題を指摘している。

そして、こうした事態を防ぐためにあるはずの査読が、チェック機能を果たしていないことも指摘している。

雑誌編集者が注目を浴びそうな論文だけを選んで掲載していると、科学者は正しいけれども退屈な論文を書かなくなり、注目を浴びそうだが間違っている論文を書くようになる。私の提案は、こうした事態を防ぐことに資するはずだ。

永井さんが立ち上げたりするつもりはないのでしょうか?

日本は欧米よりもはるかに遅れています。日本から新しいシステムを発信してもらいたいです。

私がここで提案しているシステムは、大学や公的研究所やそれらに助成金を出している政府が動かないと実現しないので、私一人ではどうしようもありません。しかしながら、研究はこうした特権階級の独占物ではないし、民間レベルでの研究はもっと活発に行われるべきであり、その実績の蓄積が研究の民主化につながると思います。システム論フォーラムが一つの例ですが、私としても、わざわざサイトを立ち上げて訪問者を集めるという面倒なことはしたくないという人のために発表とコミュニケーションの場を提供する試みを今後も考えてみることにします。

専門性と民主性のバランスをどう設計するかは人智を絞るところですね。少なくとも工作活動員を排除できれば、ネット空間上で実現可能になっている現状があるので。ただし工作員活動はそれを見越してさらに巧妙化するでしょう。最近、ブラジルで私のクレジットカードの決済が何者かによって行われそうになりました。

わたしは最近(五年以上)ブラジルには行っていません。しかし我が優秀なメインバンクは決済を見送りました。電子的に行われることをどこまでも拡張することには限界がありそうです。顔を付き合わすことのできる新たなシステムに移行すべきと思う論点を、素晴らしい貴殿の論点の中に付加する必要がありそうだと思いました。

ブラジルにいるはずのない人が行う決済を見送ったということは、「顔を付き合わすことのできるシステム」があったからではなくて、不審な決済を検知して保留するアルゴリズムによる自動判定の結果ではないでしょうか。スパムメールの削除やSEOスパムの防止などで見られるように、工作活動が巧妙になる一方で、それを自動検知するコンピュータのアルゴリズムもまた進化しているということです。もちろん、コンピュータのアルゴリズムは完全ではないし、クレジットカードの場合でも、不正ではないのに止められたりするので、最後は人間の個別判断で決めなければならない時もあるでしょう。私が提案したシステムでも、最後は人間の判断で投票がされるようになっているのは、そのためです。

ある日本の学術論文では、責任著者、あるいは筆頭著者が事前に編集長、および編集者(著者の後輩など)に連絡して裏で手を回し、査読者を指定している。そして、査読者には好意的な査読と超短期間での返答を連絡している。これは悪質である。このような事がまかり通れば、業績はいくらでも作れる。

海外と比較して日本に論文不正が多いのもそうした類の癒着が蔓延しているからなのでしょうね。